以获取网页源码是食腐工程项目的最主要和最关键性的关键性步骤,我这儿如是说怎样借助 Python 的 Requests 库以获取chan热榜网页的源码。(但是该中文网站须要登入,这儿他们而已演示应用程序登入,只但是以获取的是登入介面的源码。演示登入,源码会在后展开如是说,渐进。)

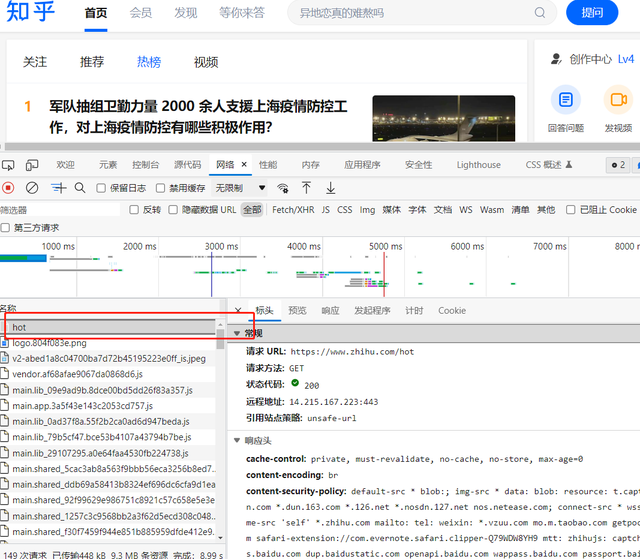

关上chan热榜,间接拷贝应用程序网页的邮箱。

将邮箱放进如下表所示标识符:

importrequestsurl =这是邮箱 千家号不容许再次出现邮箱,我们晓得是个邮箱就好res = requests.get(url).textprint(res)

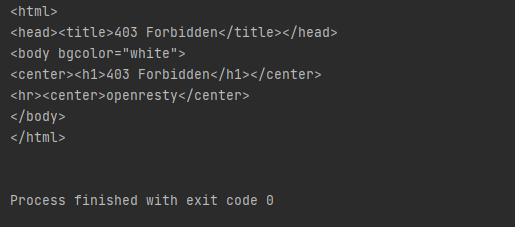

回到的结论如下表所示:

很或许,他们并没领到或者说的网页源码,即使按规矩源码中如果所含热榜中的有关新闻报道的重要信息。这原因在于chan邮箱在查阅那些重要信息的这时候都是得事先登入的,在应用程序登入情况下推送的出访允诺才会被该中文网站所普遍认可并回到文本,而 Python 的允诺却不被该中文网站所普遍认可。

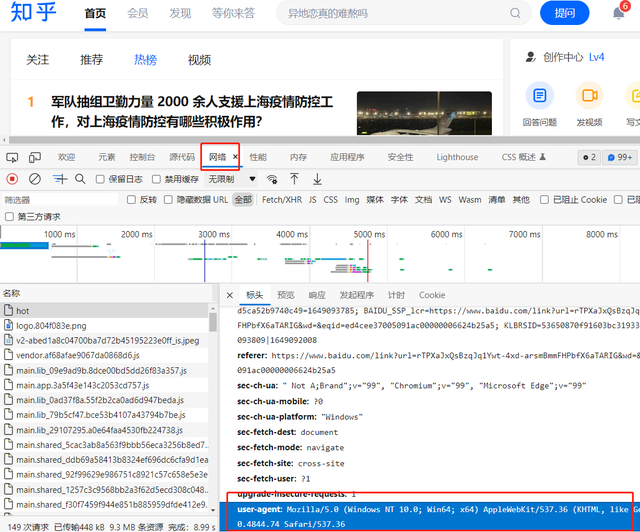

直面此种难题,就须要增设 request.get() 的 headers 模块,用以演示应用程序展开出访。headers 模块是两个包涵访客重要信息的词典,键名叫 User-Agent应用程序全权,数组充分反映了访客采用的是有种应用程序。

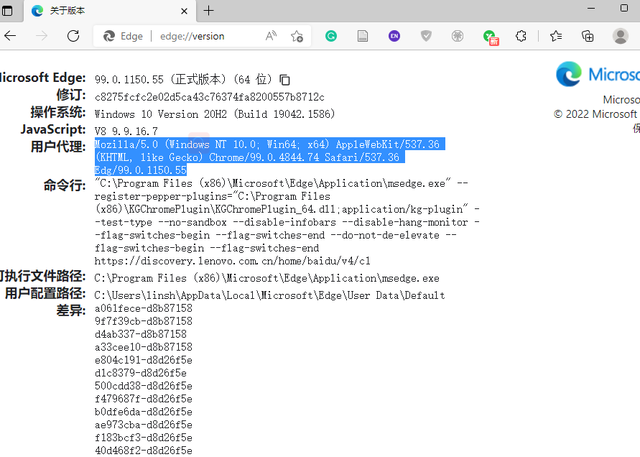

User-Agent值以获取方式1:在应用程序网页输入edge://version/(Microsoft Edge应用程序);about:version(谷歌应用程序)…可以查阅应用程序的用户全权的模块值。

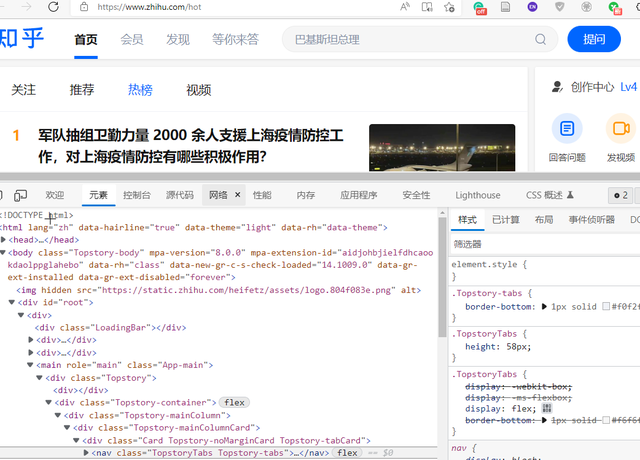

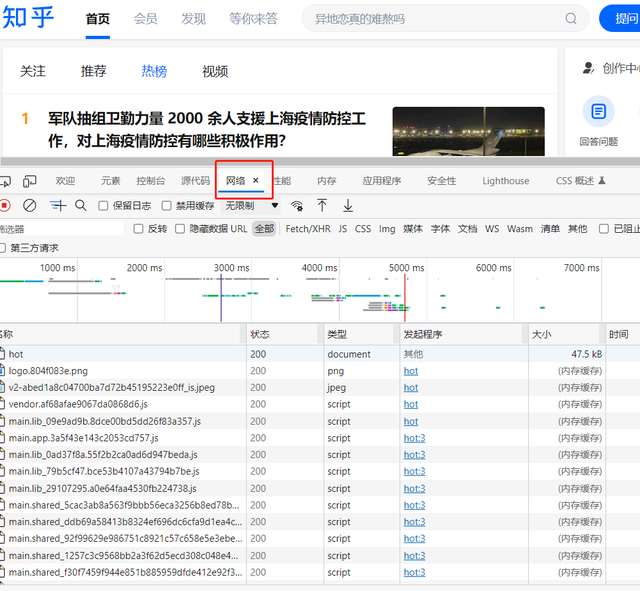

User-Agent值以获取方式2:关上开发者工具(或者右键选择检查),接着选择互联网(英文标签:network),刷新网页,随便点击两个加载文本,在右侧框中向下滑找到 User-Agent,选中右键拷贝。

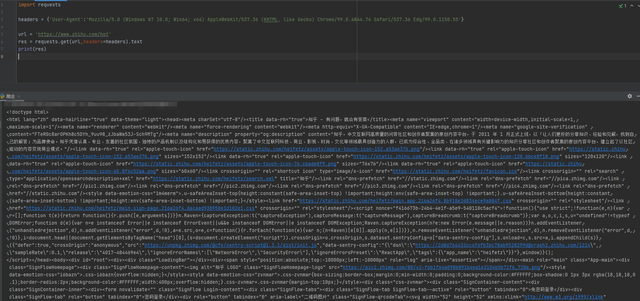

将应用程序全权模块值按如下表所示标识符采用:

importrequestsheaders = {User-Agent:Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/99.0.4844.74 Safari/537.36 Edg/99.0.1150.55}url =这是邮箱res = requests.get(url,headers=headers).textprint(res)

即可获得网页(登入页)的源码。为了爬取顺利,一般都会把 header 模块加上。后就是根据获得的源码展开分析提取存储有用的重要信息。

举报/反馈

1.本站所有资源来源于用户上传和网络,如有侵权请邮件联系站长!

2.分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3.不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4.本站提供的源码、模板、插件等其他资源,都不包含技术服务请大家谅解!

5.如有链接无法下载或失效,请联系管理员处理!

6.本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!

2.分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3.不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4.本站提供的源码、模板、插件等其他资源,都不包含技术服务请大家谅解!

5.如有链接无法下载或失效,请联系管理员处理!

6.本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!