页面截取是一类关键的控制技术,时常在许多不同的环境中采用,特别是统计数据自然科学和统计数据分析。 Python在很大程度上被认为是互联网截取的必选词汇,其原因是Python的嵌入电池组优点。 采用Python,您能在约15两分钟内采用不出100行标识符建立两个单纯的截取JAVA。 因而,不论哪种商业用途,页面截取都是每一Python开发人员必须具有的专业技能。

在他们开始亲自动手之前,他们须要后退一步棋,考虑甚么是页面截取,甚么时候应该采用它,何时能防止采用它。

如您知晓,页面截取是一类用作从中文网站手动抽取统计数据的控制技术。 关键的是要认知,页面截取是一类从各种来源(一般来说是页面)中抽取统计数据的粗略地控制技术。 假如中文网站的开发者足够多无私地提供更多API来抽取统计数据,那么出访统计数据将是一类更为稳定和强壮的形式。 因而,依照实战经验,假如中文网站提供更多API以程式设计形式索引其统计数据,请采用它。 假如API不容用,则根本无法采用互联网截取。

请亦须严格遵守有关您采用的每一中文网站的页面截取的任何人准则或管制,因为有些中文网站不容许这样做。 有了这个确切的重新认识,让他们直接进入讲义。

在本讲义中,他们将截取两个列举着著名作家名句的中文网站。

页面截取管线

他们能将web-scraping认知为包涵3个模块的管线:

浏览:浏览HTML页面

导出:导出HTML并索引他们钟爱的统计数据

储存:以某一文件格式将索引到的统计数据储存在邻近地区计算机系统中

浏览HTML

从页面中抽取任何人统计数据,从逻辑上讲,他们具体来说要浏览它。 他们有三种方法能努力做到这一点:

1.采用应用程序智能化库

您能采用Selenium等应用程序智能化库从页面浏览HTML。 Selenium容许您关上应用程序,比如说Chrome,并依照须要控制它。 您能在应用程序中关上页面,然后采用Selenium手动以获取该页面的HTML标识符。

但是,这种方法有两个很大的缺点 – 它明显变慢。 原因是运行应用程序并在应用程序中呈现HTML的开销。 此方法仅应用作特殊情况 – 他们要截取的内容在应用程序中采用JavaScript标识符,或者要求他们单击按钮/链接以以获取统计数据,Selenium能为他们执行此操作。

2.采用HTTP库

与第一类方法不同,HTTP库(例如Requests模块或Urllib)容许您发送HTTP请求,完全不须要关上任何人应用程序。 这种方法应该始终是必选,因为它比Selenium快得多。

现在让我告诉您如何采用Selenium和Requests库实现管线这个模块:

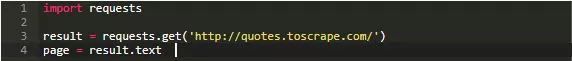

采用Requests

采用以下命令安装Requests模块:

现在您能在标识符中采用它,如下所示:

这里,对URL进行HTTP GET请求,这几乎与浏览页面同义。 然后,他们能通过出访requests.get方法返回的结果对象来以获取页面的HTML源标识符。

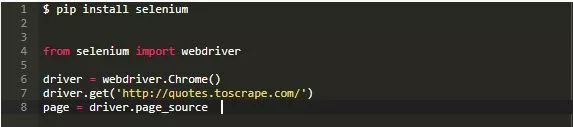

采用Selenium

您能通过pip安装selenium模块:

在这里,他们具体来说建立两个表示应用程序的webdriver对象。 这样做会在运行标识符的计算机系统上关上Chrome应用程序。 然后,通过调用webdriver对象的get方法,他们能关上URL。 最后,他们通过出访webdriver对象的page_source属性来以获取源标识符。

在这三种情况下,URL的HTML源都作为字符串储存在page变量中。

导出HTML和抽取统计数据

不必深入计算机系统自然科学理论,他们能将导出定义为分析字符串的过程,以便他们能认知其内容,从而轻松出访其中的统计数据。

在Python中,有两个库能帮助他们导出HTML:BeautifulSoup和Lxml。 Lxml是两个比BeautifulSoup更低级的框架,他们能在BeautifulSoup中采用Lxml作为后端,因而对于单纯的HTML导出,BeautifulSoup将是必选的库。

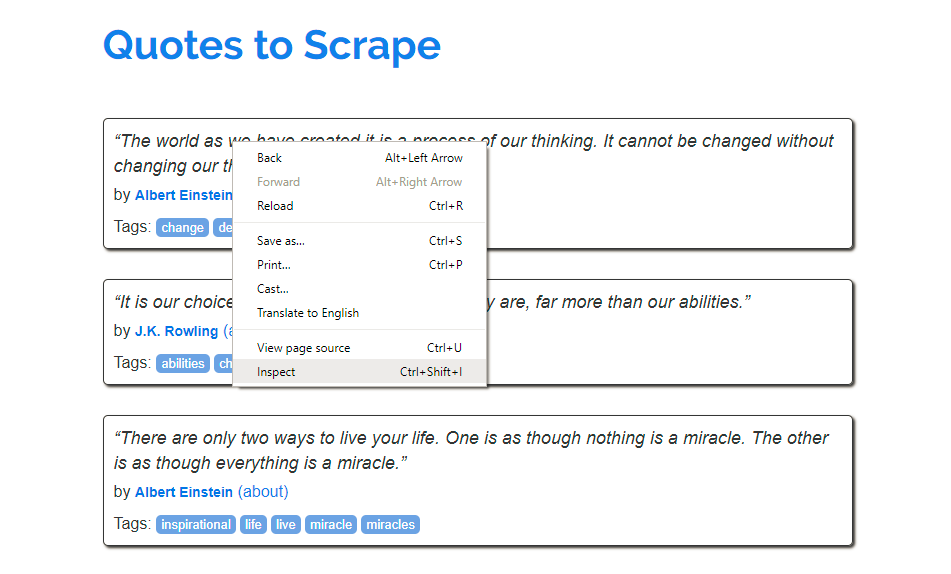

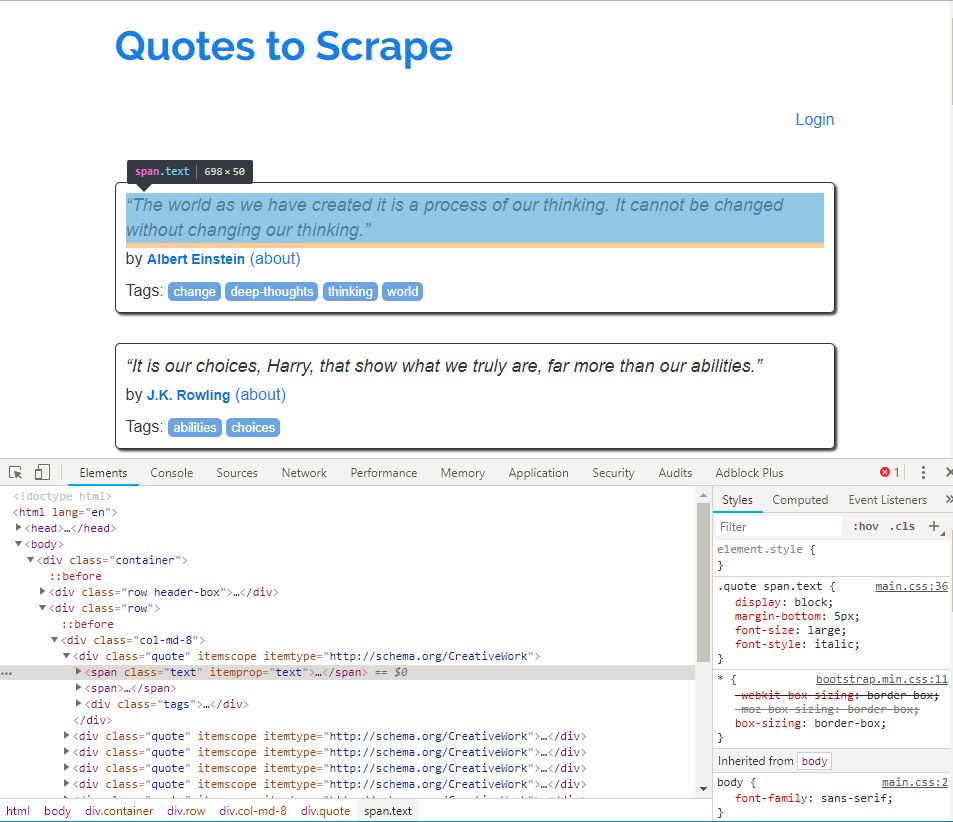

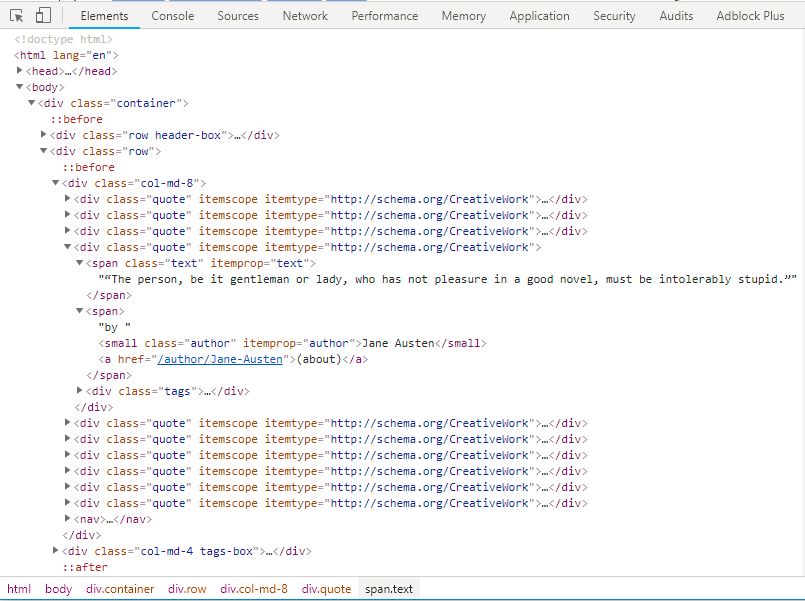

但在他们深入分析之前,他们必须分析页面的HTML,看看他们想要截取的统计数据是如何构建和定位的。只有当他们掌握了这些信息时,他们才能从导出的HTML中以获取他们想要的信息。但幸运的是,他们不必在编辑器中关上源标识符,并手动认知每一HTML元素并将其与渲染页面中的相应统计数据相关联。大多数应用程序都提供更多了两个检查器,比如Chrome的开发者工具,它使他们只需单击它们即可快速查看任何人元素的HTML标识符。

要在Chrome中执行此操作,请在Chrome中关上页面,然后右键单击要截取的统计数据,然后选择检查。在Firefox中,此选项称为Inspect Element – 这是在做相同的事情,但只是名称不同。

您会注意到Chrome窗口底部关上了两个窗格,其中包涵您单击的元素的源标识符。 浏览一下源标识符,了解他们想要截取的统计数据是如何在HTML标识符中构建的。

经过一些检查后你能认知,http://quotes.toscrape.com/上的每一引用都包涵在两个带有class =quote属性的div中。 在该div中,引用的文本在class =text的范围内,作者的名称在class =author的小标签中。 当他们实际导出HTML并抽取统计数据时,将须要此信息。

现在,让他们开始采用BeautifulSoup导出HTML页面。 但具体来说,他们必须安装它:

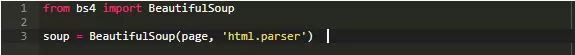

安装好之后,能像下面这样在标识符中调用:

具体来说,他们通过将页面传递给BeautifulSoup类构造函数来建立页面的导出版本。 如您所见,他们还将第二个参数html.parser传递给构造函数。 这是Beautiful Soup将用作导出传递给它的字符串的导出器的名称。 你能采用他们之前谈到过的导出器lxml,因为你已经安装了Lxml库。

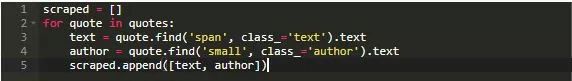

然后,他们抽取包涵class =quote的页面中的所有div标签,因为他们知道这些是包涵引用的div。 为此,Beautiful Soup 4提供更多了find_all功能。 他们将标记名称和类名称传递给find_all函数,并返回满足条件的所有标记,即包涵引用的标记。

这里须要注意的一件关键事情是,他们在这里采用树结构。 变量soup以及引用的每一元素都是树。 在某种程度上,引用的元素是较大的soup树的一部分。 不论如何,为防止进入不同的讨论,让他们继续。

他们知道引用的文本是带有class =text的span标记,而作者是带有class =author的小标记。 要从quote元素中抽取它们,他们再次采用类似的函数find。 find函数采用与find_all函数相同的参数。 唯一的区别是它返回满足条件的第两个标记,而find_all返回标记列表。 此外,他们希望出访返回对象的text属性,该对象包涵该标记中包涵的文本。

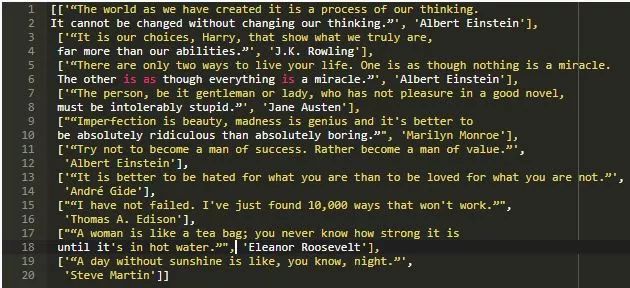

因而,正如您在标识符中看到的那样,他们遍历列表引用的所有元素,并抽取引用文本和作者名称,将它们储存在名称为scraped的列表。 在控制台上打印时,已截取的列表如下所示:

储存索引的统计数据

一旦他们获得了统计数据,他们就能以任何人他们想要的文件格式储存它,例如CSV文件,SQL统计数据库或NoSQL统计数据库。 严格来说,这一步棋不应算作截取过程的一部分,但为了完整起见,我将简要如是说它。

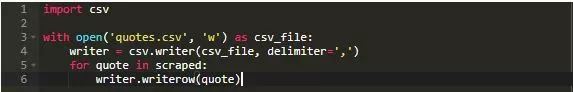

我想说最流行的储存截取统计数据的方法是将它们储存为CSV电子表格,所以我将简要如是说如何努力做到这一点。 我不会详细如是说,因为您应该参考官方的Python文档。 所以,不用多说,让他们看看标识符。

他们能看到,标识符非常明显。 他们从关上的quotes.csv文件建立两个CSV编写器对象,然后采用writerow函数逐个写入引用。 很明显,writerow函数接受两个列表作为输入,然后将其作为一行写入CSV。

结论和后续步骤

本讲义应该帮助您了解在学习自己实现单纯的scraper时基本上是甚么。 这种截取应该足以实现单纯的智能化或小规模统计数据索引。 但是假如你想有效地抽取大量统计数据,你应该研究一下截取框架,特别是Scrapy。 它能帮助您采用几行标识符编写非常快速,高效的scraper。 不论你采用甚么样的框架,在那个闪亮的表面下面,框架也采用这些非常基本的截取原则,所以认知本讲义应该能帮助你为开始截取的探险建立基础知识。

2.分享目的仅供大家学习和交流,您必须在下载后24小时内删除!

3.不得使用于非法商业用途,不得违反国家法律。否则后果自负!

4.本站提供的源码、模板、插件等其他资源,都不包含技术服务请大家谅解!

5.如有链接无法下载或失效,请联系管理员处理!

6.本站资源售价只是赞助,收取费用仅维持本站的日常运营所需!